Gemma, la nouvelle famille de modèles de Google

Gemma, la nouvelle famille de modèles ouverts et légers de Google.

Hello la team #TheDayInfo, le 21 février 2024, Google a dévoilé Gemma, une nouvelle famille de modèles ouverts et légers dont la conception repose sur les mêmes recherches et technologies qui ont servi à créer Gemini(Ancien Bard).

Le petit frère de Gemini? 😒

Humm, on peut le dire ainsi mais pas tout à fait car son utilisation est plus axé sur la création de modèles ML pour le traitement naturel du langage(NLP) donc pour les développeurs plutôt que sur la collaboration IA comme Gemini.

Introduction à Gemma

Les modèles de la famille Gemma sont en deux versions 2B et 7B.

Le modèle Gemma 2B(Deux milliards de paramètres) est destiné aux CPU et applications sur appareils tandis que le modèle Gemma 7B(Sept milliards de paramètres) est destiné aux déploiements efficients et déploiements sur CPU et GPU.

Ces nouveaux modèles sont utilisés dans la conception des modèles de machine learning en NLP(Natural Language processing).

Ce qui nous amène à notre second volet, Gemma pour les développeurs.

Gemma pour les développeurs

Il est possible de concevoir un modèle de machine learning qui générera des réponses grâce aux prompts.

Comme si je conçevais mon propre Gemini? 😲

C'est tout à fait ça et ce, dans les trois frameworks que sont TensorFlow, Jax et Pytorch. Génial non?

Et maintenant place au tutoriel qui vous permettra de prendre la main sur Gemma. Pour ce tutoriel, nous allons utiliser Colab pour ses ressources Google cloud tel que le GPU.

De prime abord, vous devez créer un compte sur Kaggle, ensuite demander l'accès à Gemma sur Gemma card et créer enfin un token.

.png) |

| Accès à Gemma sur Kaggle |

.png) |

| Accès autorisé avec un compte Kaggle validé |

.png) |

| Création de Token sur Kaggle |

Pour créer un jeton(Token), cliquez sur la photo de votre profil en haut à droite, dans les options choisissez "Paramètres" ou "Setting" selon le langage de vote navigateur, scrollez jusqu'à API et cliquez sur "Create New Token" ou "Créez un nouveau Jeton".

Un fichier Json va être téléchargé dont le contenu va ressembler à ceci👇

{"username":"thedayinfo","key":"1dec73b82128e9856a66ba46664fad80"}

Maintenant que nous avons nos paramètres de base, nous pouvons nous rendre sur Colab.

Nous allons d'abord enregistrer les informations de l'API dans la partie "Secrets" de Colab.

Cette nouvelle fonctionnalité permet de garder caché les valeurs de nos APIs.

N.B: Veuillez choisir un T4 GPU comme environnement d'exécution sur Colab.

|

| Ajout de crédentials sur Colab |

.png) |

| Importation de Keras et choix du backend |

Comme je le disais plus haut, il est possible d'utiliser Keras avec le backend avec lequel vous vous sentez à l'aise sans changer le code de votre modèle. J'ai choisi pour ce cas-ci, TensorFlow.

.png) |

| gemma_2b_en |

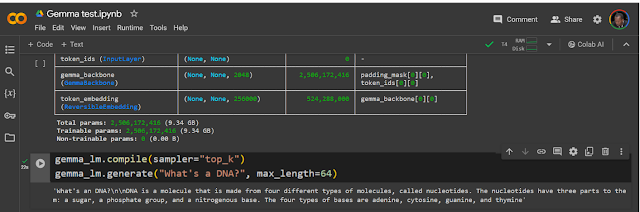

Générons un texte avec le prompt "What's a DNA?" et il nous génère une réponse.

Comme vous pouvez le voir, il est possible de créer un modèle de machine learning basé sur les LLMs comme ici Gemma grâce à Keras 3.0 qui supporte trois backends: TensorFlow, Jax et Pytorch.

Bonne semaine et prenez soin de vous !!!

Commentaires

Enregistrer un commentaire

Merci cher(ère) ami(e), tout le plaisir est pour moi.